Silnik parowy był pierwszą, produkcja seryjna – drugą, a automatyzacja trzecią rewolucją przemysłową.

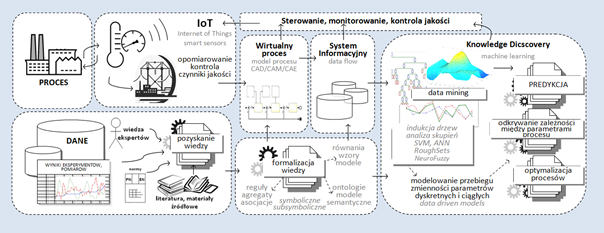

Obecnie mówi się o czwartej rewolucji (Industry 4.0) wywołanej przez systemy cyber-fizyczne, czyli systemy produkcyjne, które sprzężone są z komputerowymi metodami symulacji, sterowania, monitorowania i wizualizacji procesów produkcyjnych. Smart Factories ― fabryki inteligentne, to przedsiębiorstwa, które upatrują przewagę konkurencyjną w optymalizacji produkcji i zarządzania. Polega ona na wykorzystaniu technik sztucznej inteligencji, tj. metod zaawansowanej analizy danych pozwalających na odkrycie możliwości poprawy funkcjonowania procesów i procedur.

Czym jest Industry 4.0?

Rewolucją nie jest wynalezienie metod symulacji numerycznych procesów, które znane są od wielu lat, nie są nią nawet techniki sztucznej inteligencji, bo te również rozwijane są od dekad. Nie nazwano rewolucją stosowania robotów autonomicznych ani czujników wyposażonych w możliwość podejmowania decyzji (smart sensors). Urządzenia połączone siecią bezprzewodową i wymieniające się danymi, a więc współpracujące ze sobą bez interakcji człowieka (IoT: Internet of Things) ― nawet to nie zostało nazwane rewolucją. Dopiero, gdy te wszystkie technologie można połączyć, sprawić, by działały w zamkniętym środowisku jednej fabryki i tworzyły zintegrowany cykl produkcji i modeli wirtualnych ― dopiero wtedy możemy mówić o koncepcji Przemysłu 4.0.

Dane

Dla polskich przedsiębiorstw czwarta rewolucja oznacza konieczność usprawnień w zakresie zbierania danych z każdego obszaru działalności, zarówno produkcyjnej, w tym niezwykle szczegółowej ― na poziomie czujników, jak i logistyki, kadr czy marketingu. Dane o działalności są źródłem przewagi konkurencyjnej, tj. pozwalają określić szczegółowo, co może zostać poprawione, czy to w zakresie zapewnienia jakości poszczególnych procesów produkcyjnych, czy też na poziomie kierowniczym, w zakresie procedur.

Procesy wirtualne

Modelowanie metodami numerycznymi procesów wytwarzania pozwala inżynierom na tworzenie modeli wirtualnych procesów produkcyjnych. Nazywane są one również „cyfrowymi bliźniakami”, Digital Twin i nie tylko umożliwiają wyznaczanie właściwości produktu (czy przebiegu procesu) bez konieczności modelowania fizycznego, ale również pozwalają na optymalizację procesu bez kosztownych prób i błędów. Model wirtualny pozwala na symulację projektowanego procesu lub unowocześnianie istniejących systemów produkcyjnych. Jest wzorcem, do którego dąży proces rzeczywisty. Wyznacza normę, na podstawie której możemy monitorować realny przebieg produkcji. Żeby jednak móc pilnować właściwego przebiegu procesu, musimy posiadać wiedzę o faktycznym stanie rzeczy. Do tego służy rozproszona sieć czujników, sensorów, specjalistycznych urządzeń pomiarowych, efektorów synchronizowanych w technologii Internet of Things. Ponadto wykorzystanie specjalistycznych rodzajów efektorów, manipulatorów lub innych mechanizmów cyberautomatyki może odciążyć człowieka w zadaniach wyczerpujących oraz niebezpiecznych. Kolejną cechą takich systemów są zdecentralizowane systemy podejmowanie decyzji w oparciu o dane pochodzące z różnych źródeł i zaawansowane metody przetwarzania informacji.

Eksploracja danych

Metody uczenia maszynowego (Machine Learning), wywodzące się z badań nad sztuczną inteligencją, pozwalają na generowanie wiedzy (w postaci modeli lub reguł) na podstawie zbioru danych uczących, umożliwiając wykorzystanie tej wiedzy w automatycznym sterowaniu i podejmowaniu decyzji. Metody uczenia maszynowego niewiele różnią się od tych stosowanych w eksploracji danych (data mining), a główną różnicą jest ich przeznaczenie, tj. odbiorca wyników końcowych. Eksploracja danych dąży do odkrycia w zbiorze pewnych prawidłowości, reguł, czy też relacji pomiędzy czynnikami. Jej celem jest odkrywanie wiedzy, a odbiorcą procesu jest człowiek. Uczenie maszynowe ma również na celu odkrywanie wzorców, ale takich, które pozwolą na podejmowanie automatycznych decyzji przez komputer. Pozyskiwanie wiedzy (knowledge discovery) daje możliwość tworzenia modeli opartych na danych (data driven models), które mogą być zastosowane zarówno do przewidywania wartości ilościowych (predykcji), jak i do klasyfikowania obiektów. Jest to niezbędne w przypadku autonomicznych urządzeń i robotów, ale takie algorytmy z powodzeniem są wykorzystywane również w innych dziedzinach, takich jak medycyna (diagnostyka), marketing (zarządzanie), a nawet media społecznościowe. Znajomość zależności między parametrami procesów, możliwość ich prognozowania, pozwala na sprzężenie zwrotne i informację skierowaną z powrotem do procesu, umożliwiając optymalizację parametrów sterowania, a tym samym redukcję kosztów, podniesienie czynników jakości i skrócenie czasu.

Rys.1. Koncepcja cyberfizycznego systemu produkcyjnego

Rys.1. Koncepcja cyberfizycznego systemu produkcyjnego

Cyberfizyczne systemy produkcyjne

Procesy wirtualne, smart sensors i data mining stanowią elementy rozwoju współczesnej gospodarki z ukierunkowaniem na cyfryzację i cyberfizyczność przemysłu. Realizując modele predykcyjne, można doprowadzić do optymalizacji procesów poprzez identyfikację wpływu parametrów. Znając oczekiwane optimum i posiadając model aproksymacyjny, jesteśmy w stanie określić siłę wpływu poszczególnych składowych procesu (analiza wrażliwości), a następnie oszacować ich wpływ na wynik końcowy. Sterując zmianą parametrów, odnajdziemy optymalne wartości na wejściu sterowania. Podnosimy jakość i konkurencyjność produkcji i zarządzania.

Metody uczenia maszynowego w połączeniu z metodami formalizacji wiedzy (technikami semantycznymi) zwiększają możliwości wykorzystania wiedzy. Zespoły badawcze zajmujące się rozwojem aplikacji technologii sztucznej inteligencji od lat współpracowały w projektach dążących do budowy dziedzinowych baz wiedzy. W wielu przypadkach takie dedykowane systemy doradcze lub eksperckie stanowią hermetyczne narzędzie, niezdolne do udostępniania wiedzy innym aplikacjom czy urządzeniom. Obecnie pojawiły się przesłanki pozwalające sądzić, że możliwe będzie ponowne użycie tych baz wiedzy z wykorzystaniem ontologii i technik semantycznych.

Wiedza i przemysł

Czwarta rewolucja to wyzwanie ― integracja i interdyscyplinarność: elektronika, sztuczna inteligencja, wizualizacja i analiza danych, programowanie, inżynieria, zarządzanie ― nigdy dotąd wiedza z tak wielu dziedzin nie była zjednoczona na tak wielu poziomach działalności. O ile na polskich uczelniach ten proces trwa i widoczne są dążenia do łączenia osiągnięć z różnych dziedzin, o tyle w polskim przemyśle wciąż widać tendencje do dywersyfikacji zamiast unifikacji. Pozostaje mieć nadzieję, że koncepcja Industry 4.0 stanie się spoiwem, które umożliwi pełne wykorzystanie osiągnięć naukowych, badawczych i organizacyjnych, pomostem pomiędzy polskimi firmami a uczelniami.

Autor: Krzysztof Regulski

Katedra Informatyki Stosowanej i Modelowania

Wydział Inżynierii Metali i Informatyki Przemysłowej

Akademia Górniczo-Hutnicza

http://www.isim.agh.edu.pl